哈工大在CoNLL上斩获全球第四,车万翔博士详解背后的技术细节

2017年06月16日 11:46:12

来源:雷锋网

原标题:哈工大在CoNLL上斩获全球第四,车万翔博士详解背后的技术细节

CoNLL 系列评测是自然语言处理领域影响力最大的技术评测,每年由 ACL 的计算自然语言学习会议(Conference on Computational Natural Language Learning,CoNLL)主办。在今年 CoNLL-2017 评测(http://universaldependencies.org/conll17/)上,哈工大社会计算与信息检索研究中心取得第四名的佳绩,这也是亚洲团队所取得的最好成绩。为此,雷锋网 AI 科技评论荣幸地邀请到了哈尔滨工业大学计算机学院副教授车万翔博士做了一次专访,探讨哈工大团队本次参赛的技术细节。

车万翔博士,哈尔滨工业大学计算机学院副教授、博士生导师,斯坦福大学访问学者,合作导师 Christopher Manning 教授。现任中国中文信息学会计算语言学专业委员会委员、青年工作委员会副主任;中国计算机学会高级会员、YOCSEF 哈尔滨主席。主要研究领域为自然语言处理,在 ACL、EMNLP、AAAI、IJCAI 等国内外高水平期刊和会议上发表学术论文 40 余篇,其中 AAAI 2013 年的文章获得了最佳论文提名奖,出版教材 2 部,译著 2 部。目前承担国家自然科学基金、973 等多项科研项目。负责研发的语言技术平台(LTP)已被 600 余家单位共享,提供的在线「语言云」服务已有用户 1 万余人,并授权给百度、腾讯、华为等公司使用。2009 年,获 CoNLL 国际多语种句法和语义分析评测第 1 名。2016 年获黑龙江省科技进步一等奖;2015 和 2016 连续两年获得 Google Focused Research Award(谷歌专注研究奖);2012 年,获黑龙江省技术发明奖二等奖;2010 年获钱伟长中文信息处理科学技术奖一等奖、首届汉王青年创新奖等多项奖励。

雷锋网 AI 科技评论:首先恭喜车老师的哈工大团队获得了 CoNLL - 2017 的第四名。今年的评测任务为面向生文本的多语言通用依存分析,是否能和我们简单介绍一下今年的比赛赛制及情况?

车万翔博士:谢谢雷锋网的采访,很高兴借此机会分享我们参加此次评测的一些经验和教训。

今年的 CoNLL 评测任务为:Multilingual Parsing from Raw Text to Universal Dependencies,即面向生文本的多语言通用依存分析。从生文本(往往是篇章)出发,需要进行分句、分词、形态学分析、词性标注、依存句法分析等。此次评测提供了 45 种语言的 64 个多领域通用依存树库作为训练资源,最终面向 49 种语言的 81 个树库进行评测,其中包含 4 种训练数据中未出现的资源稀缺语言以及多种跨领域数据。全部数据来自 Google 、斯坦福等单位发起的通用依存树库(http://universaldependencies.org/),该数据的特点是虽然语言众多,但是统一制定了词性标注和句法分析的标注规范。最终评价指标为在全部树库上依存分析任务的平均 LAS(依存标签准确率)。

评测组织者包括 Google,查理大学(捷克),乌普萨拉大学(瑞典),图尔库大学(芬兰)等。数据提供及相关支持来自斯坦福大学、剑桥大学、IBM Research 等单位。

2016 年 12 月 11 日评测对外发布并开始接受报名,报名截止日期为 2017 年 4 月 15 日,共有包括卡内基梅隆大学、华盛顿大学、多伦多大学、牛津大学、爱丁堡大学、东京大学、 IBM 研究院、Facebook 等在内的 113 支队伍报名参赛。最终评测在 5 月 8 日到 14 日之间进行。

值得一提的是,此次评测运行在 TIRA 系统(http://www.tira.io/)之上。TIRA 为每支参赛队伍提供了一台虚拟机,供运行参评系统。评测期间,参评系统对组织者提供的隐藏测试数据进行分析并获得最终的评测结果,这保证了参赛队伍看不到测试数据,防止发生作弊情况。

雷锋网 AI 科技评论:哈工大参赛系统的依存句法分析是如何实现的?团队为何采用了基于转移的分析方式?

车万翔博士:目前依存分析领域两大主流方法分别是基于转移(Transition-based)和基于图(Graph-based)的依存分析。基于转移的方法是,构建一条从初始转移状态到终结状态的转移动作序列,在此过程中逐步生成依存树。其依存分析模型的目标是得到一个能够准确预测下一步转移动作的分类器。而基于图的算法将依存分析转换为在有向完全图中求解最大生成树的问题,是基于动态规划的一种图搜索算法。相较之下,基于转移的方法能获得更大范围内的特征(基于图的方法的可选特征受到动态规划的限制),此外,由于我们采用了贪婪搜索,因此基于转移的方法在预测时有相对更快的速度。除了以上两点之外,近年来,有许多基于转移的依存分析研究工作中将神经网络利用进来,有效提高了该方法的性能,而我们也一直在从事这方面的研究。因此我们最终选择了基于转移的分析方法。最终我们的系统在仅使用 1 个 CPU、8 GB 内存(实际使用了不到 4 GB)的虚拟机上,以较短的时间完成了全部语言的评测。

基于转移的方法的转移系统一般包括保存待处理词的缓存,保存正在处理词的栈和历史转移动作。我们采用的是基于转移的 List-based Arc-eager 算法(Choi and McCallum, 2013),该算法的转移系统比一般的转移系统多了一个双向队列,用于处理非投射现象,因此可以分析非投射树(弧之间有交叉的树)。

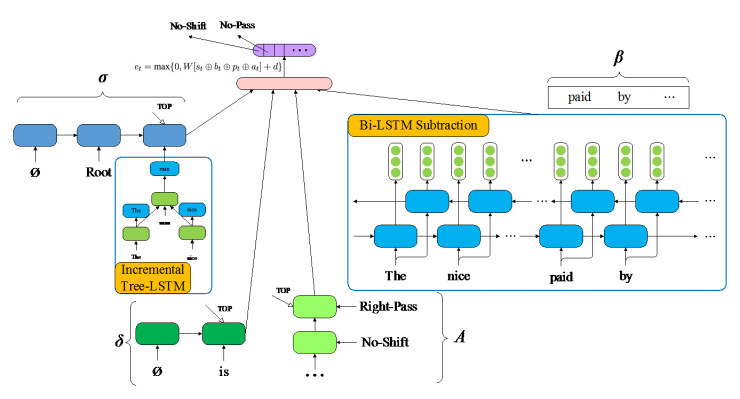

雷锋网 AI 科技评论:在本次比赛中,团队基于 Stack LSTM 的基础,采用了 Bi-LSTM Subtraction 更好地学习缓存表示,它的主要原理是怎样的?而在采用 Incremental Tree-LSTM 对栈中的子树进行建模的过程中,主要有哪些难点?

车万翔博士:在 Stack LSTM parser 中,只用一个单向 LSTM 对缓存中所有词进行建模,这样会损失已经不在缓存中的词的信息。为了利用这部分信息,我们首先用一个 Bi-LSTM 对整个句子进行建模,从而获得每个词的正向和反向 LSTM 隐层输出(分别称为该词的正向表示和反向表示)。在每个转移状态中,用当前缓存第一个词的反向表示减去最后一个词的反向表示,拼接上最后一个词的正向表示减第一个词的正向表示,就获得了当前缓存的表示向量。简单来说,就是用一个句子片段的头尾词的表示向量之差来表示这个片段。

在 Stack LSTM parser 中,使用递归神经网络(RecNN)逐步组合子树中的词和其子节点(每次组合一对),而在 Tree-LSTM 中,一个词和其所有子节点是同时组合的。在处理较大的子树的时候,递归神经网络可能遇到梯度消失问题。而 Tree-LSTM 则一定程度上缓解了梯度消失问题。由于 Tree-LSTM 中一个词和其所有子节点是同时组合的,而在依存分析过程中,一个词的子节点是逐个找到的,因此主要的难点就是如何在每找到一个词的子节点之后就进行一次更新。我们的解决方法是每次子树更新的时候,找到一个词的所有已找到的子节点,将它们与该词同时组合。事实上在分析过程中,还存在一种情况,即一个词的所有子节点都找到后,其子节点又找到了子节点,要处理这种情况,需要在每个词找到一个子节点后同时更新它的所有祖先节点。但考虑到分析速度问题,我们忽略了这种情况,仍然只更新找到子节点的词本身。系统框架如下图所示:

雷锋网 AI 科技评论:根据赛制的要求,任务中包含了 4 种训练数据中未出现的资源稀缺语言以及多种跨领域数据。那么针对资源稀缺的语言,团队采用的是什么解决方法?

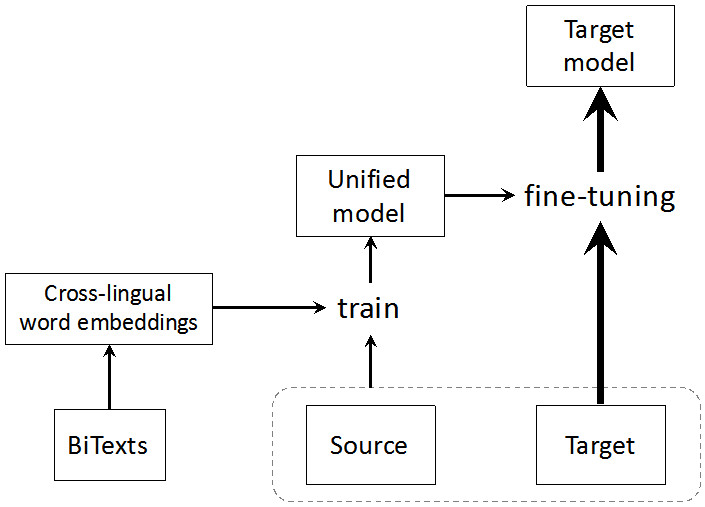

车万翔博士:我们采用模型迁移(model transfer)的方法,充分利用资源丰富语言的训练资源,来帮助对资源稀缺语言的句法分析。具体来讲,对于一种资源稀缺语言(目标语言),我们首先根据语言的形态学特征(typology)来选择与其最接近的一种(或多种)语言作为其源语言。利用源语言的训练资源,我们可以学习一个句法分析器,然后将其应用于目标语言。这种方法最大的难点是由于源语言和目标语言使用不同的词表所带来的「词汇化特征鸿沟」。为了解决这个问题,我们使用了本团队在 ACL 2015, AAAI 2016 中所提出的跨语言词汇分布表示(word embedding)以及布朗聚类(Brown cluster)学习算法,使得不同语言之间的句法分析模型能够进行「无缝」迁移。如下图所示:

此外,在目标语言端存在少量标注数据的情况下,我们利用这些数据对迁移模型进行精调(fine-tuning),更显著地提升了模型在目标语言端的性能。

类似的方法也被应用于评测中对跨领域平行数据的分析,即:利用资源丰富的源领域数据来帮助对于资源较少的目标领域数据的分析,也取得了非常显著的性能提升。

雷锋网 AI 科技评论:作为全球第四、亚洲第一的团队,您认为哈工大还可以从哪些方面提升评测系统的准确性?

车万翔博士:据目前我们能获得的材料,排名第一的斯坦福大学在词性标注环节取得了非常好的结果(准确率比第二名高 2%),我们都知道,词性对句法分析的影响非常大,因此如何充分利用语言的特性,尤其是那些形态学丰富语言(在本次评测中这些语言占绝大部分)的特性,获得更好的词性标注结果,是进一步提升评测系统准确率的一个可行方案。我们在此次评测中也充分考虑了我们所擅长语言的特性,如对汉语(繁体)、日语和越南语这些语言研发了专门的分词系统,最终有效提高了这些语言句法分析的准确率。

另外,本次评测排名二、三位的系统均采用了多个系统进行集成学习的方法,除了基于转移的系统外,他们还利用了基于图的依存句法分析系统。虽然将这些系统进行集成会取得更好的效果,但是会极大地降低句法分析系统的速度,因此我们本次评测并没有采用复杂的集成学习方法。当然,为兼顾这两方面,我们也正在研究如何在不损失系统效率的前提下,达到集成学习的效果。我们的初步试验已经取得了不错的效果。

雷锋网 AI 科技评论:本次参赛的其它团队包括了 CMU、斯坦福等多间名校,也有像 Facebook 的企业,但从排名结果上看,排在前列的清一色都是高校,且得分非常出色。您认为高校取得大比例优势的原因可能在哪些地方?

车万翔博士:句法分析是自然语言处理的核心且基础的研究问题,无法像机器翻译、问答系统一样直接对终端用户提供服务,所以目前看还没有引起企业的广泛关注,而从事基础研究的高校对其更感兴趣,个别企业即便应用句法分析,往往也是直接向高校购买使用权。而近年来,随着句法分析技术的成熟,它已在细粒度情感分析、关系抽取等很多应用中发挥了良好的效果,相信这项技术会引起越来越多企业的兴趣和重视。

雷锋网 AI 科技评论:您的团队此前在 2005、2008 及 2009 年的 CoNLL 上都获得了优异的成绩,鉴于每年的任务类型与难度都不同,是否能和我们介绍一下 CoNLL 历年任务的整体变化趋势?是否会向解决产业界的实际问题靠拢?

车万翔博士:2005 年,我们参加了 CoNLL 组织的语义角色标注评测;2008 参加了英文句法分析和语义角色标注的联合评测(我们获得了第二名);2009 参加了 7 种语言的句法分析和语义角色标注联合评测(我们获得了第一名),接着几年相继举行了指代消解、语法纠错、篇章关系分析等评测。CoNLL 每年会征集评测题目,最终根据研究内容是否前沿、标注数据是否高质量、组织单位经验是否丰富等方面评选出一项最终的评测内容。根据 CoNLL 的传统,相关的评测往往会连续举行两年。最终的评测数据会向学术界公开以便开展后续的研究,所以即使评测结束,也会有大量的研究工作在这些数据上进行。

之前的 CoNLL 评测都是学术界主导的,所以内容多偏向自然语言处理的基础研究问题,随着自然语言处理技术逐渐受到产业界的重视,相信以后会有越来越多企业的参与,因此不排除会组织一些具有面向实际应用的评测。

雷锋网 AI 科技评论:哈工大社会计算与信息检索研究中心经过多年技术积累研发的「语言技术平台(LTP),为产业界及学术界提供多种高效精准的自然语言处理技术。目前,学术版 LTP 已共享给 500 多家研究机构免费使用,百度、腾讯、华为、金山等企业付费使用 LTP 商业版本。想了解下目前 LTP 的发展状况?

车万翔博士:LTP 除了您说的离线版本外,还提供在线服务,我们将其命名为「语言云」(http://www.ltp-cloud.com/)。开发者可以直接在线调用 LTP 的各项服务,而无需购置额外的硬件和配置自己的运行环境,同时还能获得最新的功能。

在研究上,目前的重点是语义依存图分析,即跨越句法分析和语义角色标注两个阶段,直接分析句子中所有可能存在的实词间的语义关系。目前我们已经标注了 2 万句语义依存图语料库,并于 2012 和 2016 年组织了两次 SemEval 的国际评测。

另外,我们也在逐步使用最新的深度学习模型更新各个模块,目前依存句法分析、语义角色标注和语义依存图分析等模块已经完成升级,而考虑到运行速度等原因,更底层的分词、词性标注和命名实体模块仍然使用的是基于人工特征的模型。因此,如何对这些深度学习模型进行加速也是我们的一个研究课题。

雷锋网 AI 科技评论:在句法语义分析领域,目前还有哪些亟待解决的问题?作为在这一领域走在前沿的高校,哈工大计划从哪些方面入手?

车万翔博士:与图像处理、语音识别不同,句法语义分析任务是语言学家创造的研究内容,因此普罗大众很难参与到数据的标注中,导致这些任务很难获得充足的训练数据。所以如何解决数据不足是句法语义分析领域一个亟待解决的问题。我们所提出的基于「伪数据」的方法可以很好的弥补这一不足。所谓「伪数据」,指的是不曾面向所研究的任务进行人工标注的带标签训练数据,标签是样本的近似答案(伪),而不是精确答案。如我们之前介绍的利用多语言这种「伪数据」,使用模型迁移的方法帮助句法语义分析;另外,多种自然语言处理任务或者同一任务的不同规范数据也可以互相帮助,我们就曾提出多使用多任务学习的方法达到这一目的。

作为底层技术,句法语义分析最终的目标是帮助上层应用,然而目前的句法语义分析标准都是由语言学家创造的,而这些标准是否适用于上层应用呢?对于不同的应用,是否应该采用不同的标准呢?这些问题可能是除准确率不高外,句法语义分析在应用时所面临的最主要问题。因此,我们有必要使用自动的方法,为不同的任务归纳出自适应的句法语义分析结果,从而提高其适应性,更好的帮助上层应用提高分析精度。

- 社会

- 娱乐

- 生活

- 探索

- 历史

- 搜奇

网罗天下

凤凰资讯官方微信

视频

-

李咏珍贵私人照曝光:24岁结婚照甜蜜青涩

播放数:145391

-

金庸去世享年94岁,三版“小龙女”李若彤刘亦菲陈妍希悼念

播放数:3277

-

章泽天棒球写真旧照曝光 穿清华校服肤白貌美嫩出水

播放数:143449

-

老年痴呆男子走失10天 在离家1公里工地与工人同住

播放数:165128